本文转自CashWar5年小我私人站长,创业在路上,下面用5000字的长文告诉你,获取知乎流量的准确姿势,思绪 + 实操知行合一

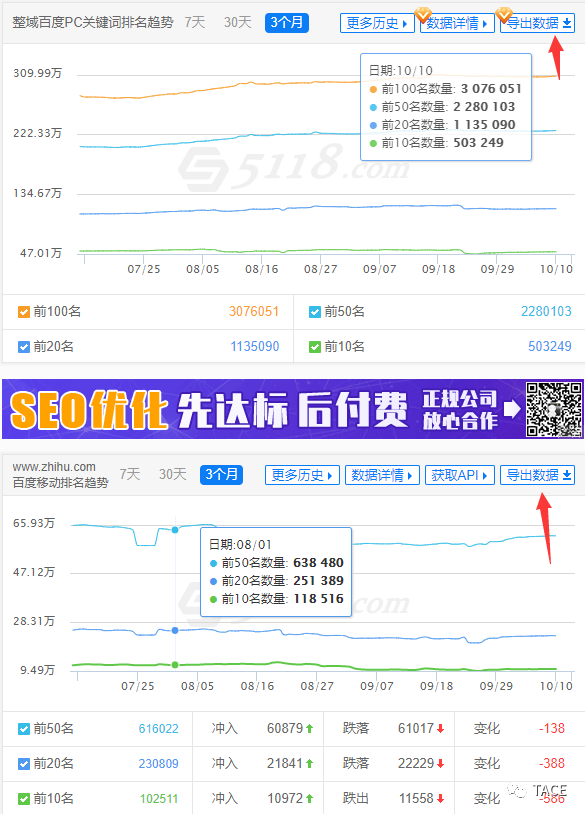

凭证我内陆数据的不完全统计(知乎百度top3关键词)

百度PC端关键词总流量为:1亿2743万

知乎现实获取总流量为:1亿2743万 x 0.15(平均点击率) = 1911万

这只是单看PC端,一个跨越2000W的流量时机摆在我们眼前

一切依赖互联网赚钱的条件,就是必须先获取流量,而现在流量比黄金还名贵

真真相形是,我身边已经有5+位的同伙,在近半年内,依赖此次时机获得了6W~25W不等的收益

而我们只需要一双勤劳的双手和一个头脑清晰的大脑

那么

-

为什么会有这个流量时机?

-

流量时机详细指的是什么?

-

我们如何从中获取流量?

-

…..

下面,让我来为你打开这扇流量的大门

1. 资源的游戏

在“江湖”上撒播着这么一段话,大致内容是:

站长收割机,流量截胡达人百度daddy在2019年8月跟投知乎,快手领头,随后,百度对知乎提权,流量显示节节攀升

那时我看到这段话的时刻,对接受的信息量打了一个问号,为什么?

熟悉流传学的同伙应该知道一条基本原则:

对于任何事情,我们要只管关注事实判断,而非价值判断

由于事实判断是确凿的,能够杀青共识 ;而价值判断是依赖于视角和态度的,可以有多种解读

这里的投资事宜为事实形貌,后面发生的影响为价值形貌

然而就这么一个简朴的事实性形貌网上却有N个版本,有说错时间点的,还有说错投资方的

进行验证后,你还会发现百度也投资过快手,可能是另外一个时机?

有时刻思绪就是凭证事实发散出来

那么关于价值判断,是不是真的有流量增进?是不是真提权?

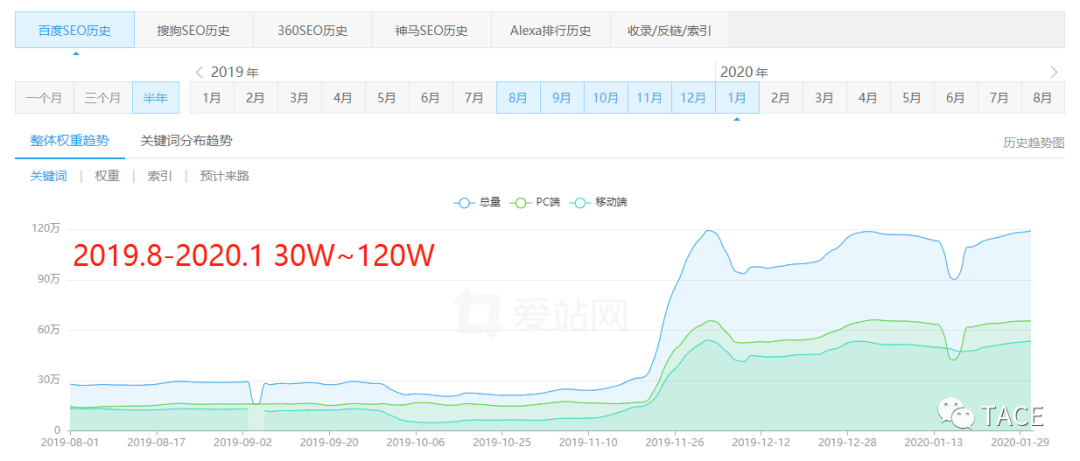

直接上数据验证(这里从投资时间点2019.8分段取爱站半年的数据,稍有误差并无大碍):

词量数据

通过词量数据我们可以考察到以下2点:

通过词量数据我们可以考察到以下2点:

-

从2019年11月中旬最先,流量跳跃式增进,词量从30W涨到270W,近10倍!

-

从2020年7月最先,流量增进放缓,但仍保持增进趋势

那么,这些流量是以何种方式增进的?

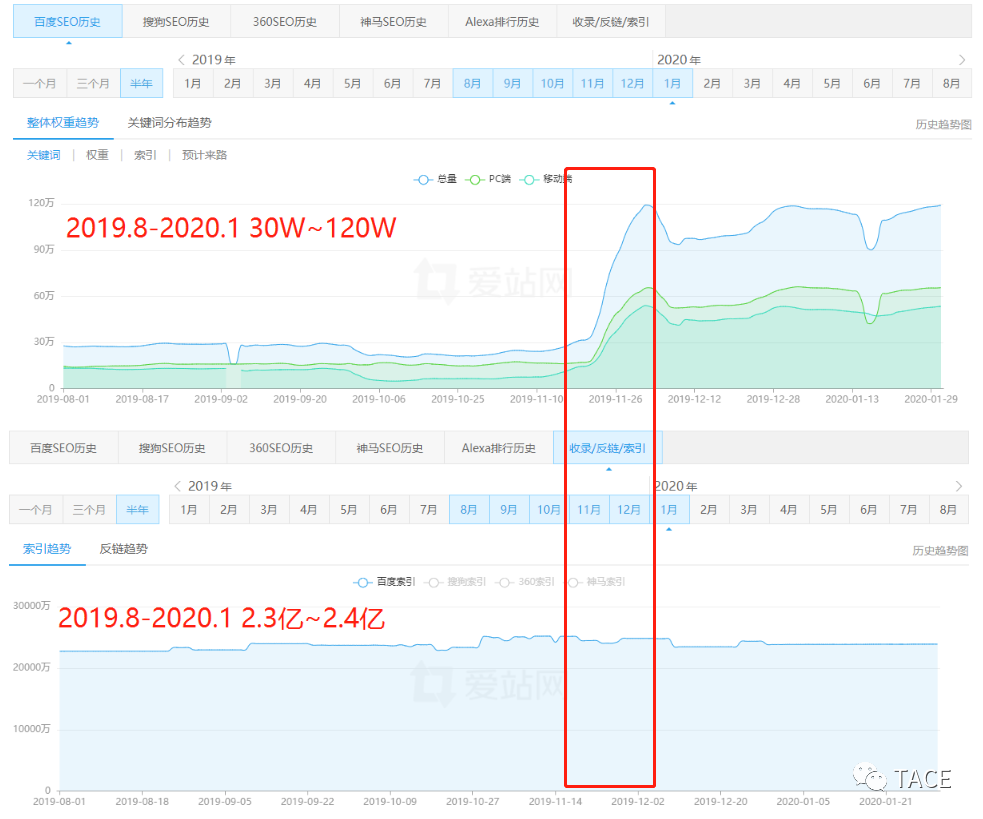

收录数据

通过收录数据我们可以考察到以下两点:

通过收录数据我们可以考察到以下两点:

-

虽然数据口径差异,但在流量跳跃式增耐久间,收录量并无增进趋势,也就是说,原收录页面在对应搜索词下的排名提升了,提权实锤

-

当已收录的页面不能笼罩更多搜索词的时刻,百度给知乎的定向流量将到达临界值,嗝~

上面的剖析很容易造成一种“空话感”,由于剖析效果跟首次吸收的信息基真相同,我们的大脑不能处置相同的信息

这恰恰是两个头脑方式“归纳法”和“演绎法”的差异之处

若是不做验证,归纳头脑隐含假设了百度提权是真实的,导致后面的动作所有基于一个假设

而演绎头脑的每一步完全基于条件为“真”的条件,想想看,若是剖析效果相反会导致什么效果

在这个信息爆炸的时代,我们着实太需要筛选信息的能力,其中保持自力思索显得尤为主要,但自力思索并不是针对everything都要提出差异看法

有用思索是必须确定在足够的知识积累之上,否则就是盲目思索

若是身处生疏领域,学习偕行仍然是不错的选择

那么虽然流量增进放缓,但云云伟大的流量知乎并没有全量“吞下”,现在仍然有且一定有时机来使用这个盈利期获取流量而且赚钱

Let’s keep going !

2. SEO?

收录?排名?提权?若是你发生了疑问,那你可能还不太领会SEO这个领域,下面简要形貌

SEO即通过领会搜索引擎(以下简称SE)的规则来调整网站,使其在目的搜索引擎上的排名提高,到达获取流量的目的

-

收录:SE的爬虫系统抓取网页后,缓存在服务器上的行为

-

权重:SE对站点的综合评分,排名的主要依据

-

排名:页面缓存在搜索效果中的排列位置

以上3点均为动态转变

那么,一个搜索流量是如何发生的呢?

首先用户输入搜索词(query),向SE提议搜索请求,SE将已缓存的页面通过算法进行排名盘算,然后返回给前端(浏览器),用户考察搜索效果,凭证自己的喜欢从搜索效果中点击页面

一个页面要想有流量,就得先有收录(被SE缓存),然后还得排名靠前(top10),然后还得有人搜(搜索量),最后还得看了让人想点击(问题+形貌)

在点击的环节,知乎具有主要的先天优势,经由多年“知识型”平台的定位与生长,用户对知乎品牌确定起自然的信托感,可能导致即便排名不在前3名,但仍然能获得跨越同位大盘的点击率

此次双剑合璧,百度给知乎做定向流量,而知乎又将流量效率提升了一截,美哉美哉

3. 蓝海问题 + 蓝海流量

那么我们的时机在哪呢?

宏宏最近缺钱,于是去百度上搜了“怎么来钱快”(真实数据,仅做示例),发现知乎某个页面排名第1

然后小手一抖点击进入,望着空荡荡的页面,面部神色发生了细微的转变

坑爹呢这是!

5年的网赚履历给了我敏锐的嗅觉,这是时机

于是我拿到了百万级关键词+知乎数据,筛选剖析后发现,有相当一部门问题页面有搜索流量然则存在以下情形:

-

回覆未解决搜索需求

-

回覆质量低

-

回覆少

-

回覆前N名赞少

-

….

那么我们能不能找到这类问题,自己编写谜底,然后使得排名靠前,向我们自己的载体(微信 / 民众号等)导流?

谜底是一定的!

综上所述,有搜索流量而且竞争低的问题,我们统称为“蓝海问题”,这些问题流量的聚集,我们统称为“蓝海流量”

下面来个小炸弹,同伙们体验先~(SE排名是动态的,人人现实搜索可能略有收支,另外思考到果然性,也许选了一个例子)

BOOM!没错就是gay,统一个问题PC和移动端排名都是第2,移动月均搜索量44.7W,PC月均搜索量9.5W,加起来50W,排名第2的点击率为20%左右,也就是说这个问题一个月有10W的SEO流量,内里的回覆呢?

第1名只有58个赞,有时机上去吗?有!有方式变现吗?

国产,社交,纳斯达克,嗯(不得不感伤,闷声发大财的人着实是太多了…)

4. 突破认知局限

有些同伙们可能到这里就坐不住了,脑子里最先构想所在行业应该如何操作

可是,万一你所在的行业没有蓝海流量呢?为什么一定要在你熟悉的领域做呢?

流量能手的头脑,从来都是大盘头脑,即以全局的视野来思索问题

而此次,我们要剖析知乎整体搜索流量的漫衍,那里有蓝海流量,我们就去到哪,而不只局限于某个问题,某个行业

甚至知乎好物完全可以基于蓝海流量的头脑

始终记着我们的目的只有一个,那就是赚钱

同时,这也是我写【TACE】(Traffic ACE,流量能手)这个民众号的主要头脑,只不事厥后去折腾项目,很少发文,咳咳….

前面讲了不少内容,那是由于我想把“道”这个层面讲清晰,即为什么这么干;而“法”是死的,规则发生转变,方式立刻失效

举个例子:特斯拉降生之初,电池成本比那时市面上低了10倍,CEO马斯克为什么能做到?

那是由于他的道是“物理学头脑”,把事物拆解成最小单元追求解决方案(TED有演讲)

然则,80%的人都喜欢直接获得方式,why?

爸爸说他听爷爷的姥爷说过,在几十万年前,人类还在狩猎阶段的时刻,为了存活下去,才降生了大脑

而大脑的进化需要上百万年,人类降生历史不外才二十万年左右,也就是说现在我们照样用着“旧脑子”

其中“旧脑子”一个显著的特点是最小作用力原理,人类天生会默认做出消耗脑力低的行为,即能不用脑就不用脑,而原理的学习用脑水平较高

包罗我,每当自己懒得动脑的时刻,我就取笑自己是个原始人,咳咳…

那么下面,就让我们一步步的进入“战场”

5. 打造百万级词库

词库是用户搜索词和词属性的聚集

我们尽可能的网络N个渠道的关键词,由于每个渠道或第三方平台都有他的局限性

在流量能手眼里,词库里躺的不是一个个的关键词,而是一张张的RMB

以搜索流量的视角来看,在大多数情形下,加词即是加流量

你能找到别人找不到的词,你就能拿到别人拿不到的流量,从而赚到别人赚不到的钱

关于数据的储存名堂,小我私人建议直接使用csv形式,以逗号为离开符的内陆文件储存,相比于mysql类的数据库,用Bash shell来查询和剖析不要太利便

拿词渠道:

-

5118

-

爱站

-

站长之家

-

…

下面我用5118举例

5.1 母词获取

1)5118

划分下载百度PC关键词和移动关键词,离开处置

没有会员的同伙自行淘宝,有企业版的同伙建议全量导出

接下来的步骤,我们会最先涉及一些编程知识:

Bash shell(Linux) + Python

由于此次数据盘算的需求通例工具已经不能知足,以是我们要动用“神秘”的编程气力

我自己已经所有开发完毕,部门简朴的Bash shell下令行直接在文章内给出

然则我信托就这一点会让80%的人知难而退,可是包罗我,谁又不是从小白一步步走过来的呢?

编程真的没有那么难,trust me!若是可以,告诉自己做那20%

整站SEO优化有4个细节因素值得注意的

另外请记着,我们不是要成为一个专业的程序员,编程能力能知足我们当前所需就好

2)初始处置

-

转码(GBK > UTF-8),由于5118给出的数据编码是GBK,而Linux里需要UTF-8

-

只输出关键词,不使用其他数据,由于第三方数据的准确度着实差强人意,像5118这种量级天天的更新量少说也要1亿,成本摆在这

-

获取前100名

第一由于数据准度低,后面我们要自己验证数据

第二前面提到过动态排名 & 百度提权,在你获取数据和验证数据中央存在时间差,在时间差里排名可能已经发生了转变

bash shell:

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(0, 92, 197);">cat</span></span> 输入文件名| iconv -c -f GB18030 -t utf-<span style="box-sizing: inherit;"><span style="box-sizing: inherit;">8</span></span>| grep -Ev <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">"整域百度PC关键词排名列表|百度指数|100以外"</span></span>|awk -F, <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">'{print </span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);"><span style="box-sizing: inherit;">$1</span></span></span><span style="box-sizing: inherit; color: rgb(3, 47, 98);">}'</span></span> > 输出文件名</span>

3)关键词整理

-

特殊符号

<span style="box-sizing: inherit; color: rgb(89, 89, 89); letter-spacing: 1px;"><span style="box-sizing: inherit; color: rgb(111, 66, 193);">[\s+\.\!\?\/_,$%^*()+"\']</span>+|<span style="box-sizing: inherit; color: rgb(111, 66, 193);">[+——!,::。√?、~@#¥%……&*()“”《》~]</span></span>

异常容易忽视的一步,许多人自然信托差异渠道产出的关键词数据(包罗百度),然则“流量能手,”与“流量能手”的搜索量数据差了十万八千里

-

网站

<span style="box-sizing: inherit; color: rgb(89, 89, 89); letter-spacing: 1px;">www<span style="box-sizing: inherit;">|com|</span>cn<span style="box-sizing: inherit;">|cc|</span>top<span style="box-sizing: inherit;">|net|</span>org<span style="box-sizing: inherit;">|net|</span>cn<span style="box-sizing: inherit;">|rog|</span>cn<span style="box-sizing: inherit;">|tv|</span>info<span style="box-sizing: inherit;">|wang|</span>biz<span style="box-sizing: inherit;">|club|</span>top<span style="box-sizing: inherit;">|vip</span></span><span style="box-sizing: inherit;"> </span>

-

年份替换,例如2010年替换为2020年

-

中文长度 >=2 (可选)

4)去敏感词 非法词汇你明白,这里我们使用了DFA算法,平均处置一个关键词不到0.1s

5) 去重 去重是异常主要的一步,但对内存要求对照高,也就是说你要去重的文件巨细不能跨越可使用内存巨细

现在的解决方式是用sort + uniq,先用split将目的文件支解,然后用sort逐个排序,然后sort+uniq合并去重

虽然没有大幅削减内存使用巨细,但提升了盘算效率

bash shell 简版:

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(111, 66, 193);">cat</span></span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">输入文件名 | sort | uniq > 输入文件名</span></span>

bash shell 大数据版:

<span style="box-sizing: inherit;">#!<span style="box-sizing: inherit;">/bin/</span>bash</span>

<span style="box-sizing: inherit;">#下令行参数:</span>

<span style="box-sizing: inherit;">#$<span style="box-sizing: inherit;">1</span> 输入文件</span>

<span style="box-sizing: inherit;">#$<span style="box-sizing: inherit;">2</span> 输出文件</span>

<span style="box-sizing: inherit;">basepath=$(<span style="box-sizing: inherit;">cd</span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">`dirname </span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">$0</span></span><span style="box-sizing: inherit; color: rgb(3, 47, 98);">`</span>; <span style="box-sizing: inherit;">pwd</span>)</span>

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;">echo</span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">`date`</span> <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">"[wordsUniq.sh DEBUG INFO] 最先文件支解..."</span></span></span>

<span style="box-sizing: inherit;">split -l300000 <span style="box-sizing: inherit;">$<span style="box-sizing: inherit;">1</span></span> <span style="box-sizing: inherit;">${basepath}</span>/words_split/split_ <span style="box-sizing: inherit;">#文件支解</span></span>

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;">echo</span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">`date`</span> <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">"[wordsUniq.sh DEBUG INFO] 最先单个排序..."</span></span></span>

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(215, 58, 73);">for</span></span> f <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(215, 58, 73);">in</span></span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">`ls </span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);"><span style="box-sizing: inherit;">${basepath}</span></span></span><span style="box-sizing: inherit; color: rgb(3, 47, 98);">/words_split/`</span></span>

<span style="box-sizing: inherit;">do</span>

<span style="box-sizing: inherit;">sort <span style="box-sizing: inherit;">${basepath}</span>/words_split/<span style="box-sizing: inherit;">${f}</span> > <span style="box-sizing: inherit;">${basepath}</span>/words_split/<span style="box-sizing: inherit;">${f}</span>.sort <span style="box-sizing: inherit;">#单个排序</span></span>

<span style="box-sizing: inherit;">done</span>

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;">echo</span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">`date`</span> <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">"[wordsUniq.sh DEBUG INFO] 最先合并去重..."</span></span></span>

<span style="box-sizing: inherit;">sort -sm <span style="box-sizing: inherit;">${basepath}</span>/words_split<span style="box-sizing: inherit; color: rgb(106, 115, 125);">/*.sort|uniq > </span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(106, 115, 125);">$2</span></span></span>

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(106, 115, 125);">echo</span></span><span style="box-sizing: inherit; color: rgb(106, 115, 125);"> `date` </span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(106, 115, 125);">"[wordsUniq.sh DEBUG INFO] 删除缓存数据..."</span></span><span style="box-sizing: inherit; color: rgb(106, 115, 125);">rm </span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(106, 115, 125);">${basepath}</span></span><span style="box-sizing: inherit; color: rgb(106, 115, 125);">/words_split/*</span></span>

使用方式:

储存为filename.sh文件,在当前目录确定words_split文件夹,然后使用如下下令行,输入输出文件均可指定路径

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(111, 66, 193);">sh</span></span> <span style="box-sizing: inherit; color: rgb(3, 47, 98);">剧本名称</span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">.sh</span></span><span style="box-sizing: inherit; color: rgb(3, 47, 98);"> 输入文件 输出文件</span></span>

OK,处置完毕,现在我们已经获得了两份异常“清洁”的母词数据,即知乎百度PC关键词和移动关键词

5.2 词扩展

词扩展即对获得的母词进行扩展,由于一个页面可能掷中多个相关的关键词

进而我们可以假设,从第三方平台获取的词只是他们所能找到的,当前知乎所能掷中的词的子集

我们要尽可能的把其他部门的词找出来,从而对照准确的预估一个问题页面的百度流量

假设现在有A和B两个问题,在你的词库中,A掷中50个关键词,总流量为1W,B掷中10个关键词,流量为100

那么你可能将B问题忽略掉,只处置A问题

可是,B问题现实上掷中了100个关键词,流量为10W

这样由于数据的不完整性造成了信息差,进而直接错过了获取这些流量的时机

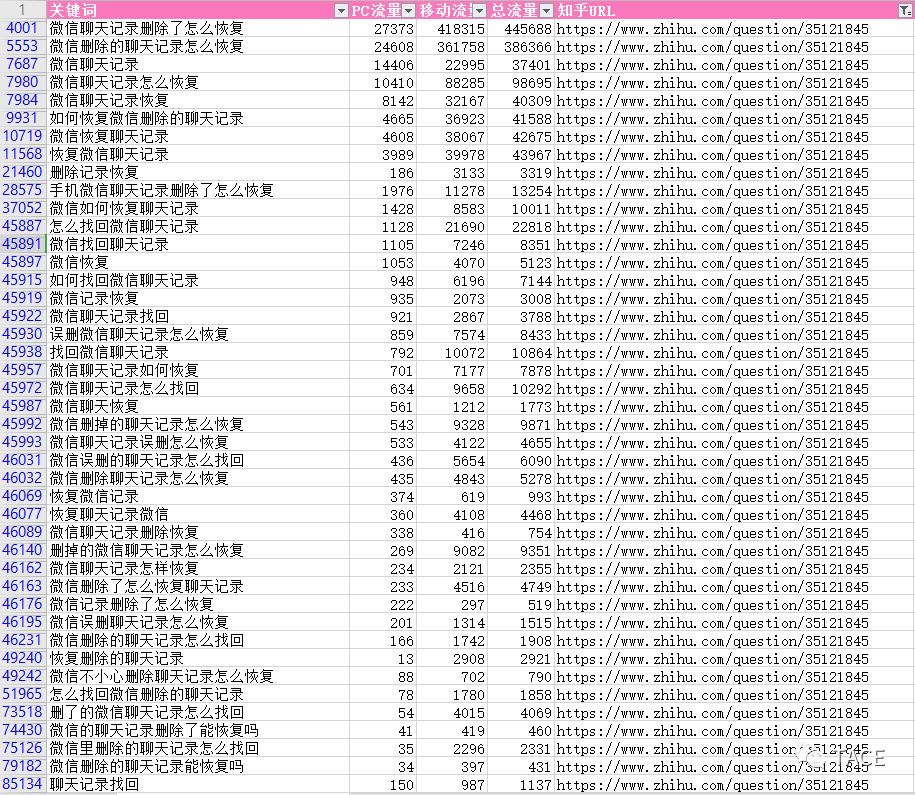

举个例子:

https://www.zhihu.com/question/35121845

经由扩展,这个页面共掷中47个关键词,PC+移动总流量为132W,广告太多知乎被迫风控提醒,下面是展示该部门数据

怎么样,是不是最先逐步感受到数据的魅力了?打起精神,Let’s keep going!

由于只做百度流量,下面只使用百度来扩展

1)相关搜索 + 下拉框词抓取

许多人只知道抓这两个渠道,并不知道这两个渠道的性子:

-

相关搜索

相关搜索为横向扩展,大部门为跨关键词主题的相关扩展,其中可能泛起主题严重漂移的情形,为保证相关性,只抓取一轮

-

下拉框

下拉框为纵向扩展,大部门在关键词的末端追加词缀

说明渠道性子的意义在于,关键词这种文本数据,扩展偏向有且只有这两个,其他扩展渠道方式都是这两个基本偏向的叠加或者变种

由于差异端产出的数据可能差异,以是我们要把PC端和移动端的母词,划分进行同端口的扩展

即PC母词抓PC相关搜索 + PC下拉框,移动母词抓移动相关搜索 + 下拉框

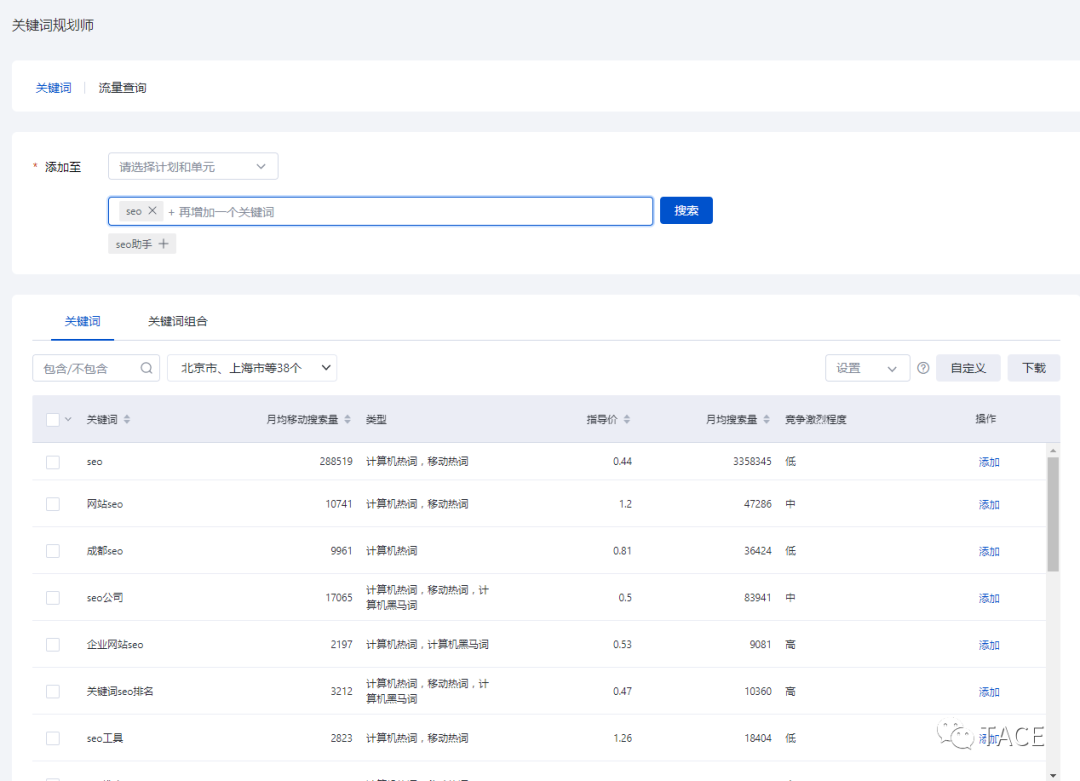

2)百度推广后台词扩展

路径为:注册/登录 > 进入搜索推广 > 推广管理 > 关键词计划师 > 关键词

注册免费,另外你还可以使用艾奇SEM工具/斗牛SEO工具等

3)词处置

先将各个渠道的词分端口合并

bash shell:

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(215, 58, 73);">cat</span></span> <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(215, 58, 73);">file1</span></span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(111, 66, 193);">.txt</span></span> <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(215, 58, 73);">file2</span></span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(111, 66, 193);">.txt</span></span> > <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(215, 58, 73);">all</span></span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(111, 66, 193);">.txt</span></span></span>

然后重复【5.1母词获取】的关键词整理和去重部门

5.3 获取关键词流量

同样使用到百度推广后台的关键词计划师,但使用的是“流量查询”的功效

这是百度官方给出的流量数据,以前的数据口径是日搜索量,现在酿成了月搜索量,不外并无大碍

有的同伙可能发生疑问,为什么不先抓排名筛选数据,减轻下一步的数据量压力?

由于关键词计划师一次能查询1000个!10W个关键词只需查询100次!

而且实测证实获取一次cookie可跨天使用,并保持10+个小时的有用登录(准许我,请务必下手轻一点)

1)流量数据获取

通过模拟登录的方式post关键词数据

2)数据筛选

每个端只保留搜索量 >= N的关键词(数值自界说)

你可以在数据获取的同时去做筛选,也可以拆开另做一个筛选步骤,这里小我私人建议后者,万一指标不合理还有重新筛选的余地

bash shell:

<span style="box-sizing: inherit;"><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(0, 92, 197);">cat</span></span> file.txt | awk -F, <span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);">'{</span><span style="box-sizing: inherit;"><span style="box-sizing: inherit; color: rgb(3, 47, 98);"><span style="box-sizing: inherit;">$2</span></span></span><span style="box-sizing: inherit; color: rgb(3, 47, 98);">>=100}'</span></span> > file_new.txt</span>

5.4 获取关键词排名

划分获取各端的排名数据,只保留

https://www.zhihu.com/question/{问题ID}

这个url特征下,前10名的关键词,以及储存对应的问题url

5.5 可获取流量

关键词流量并不即是知乎问题页面能获取的现实流量

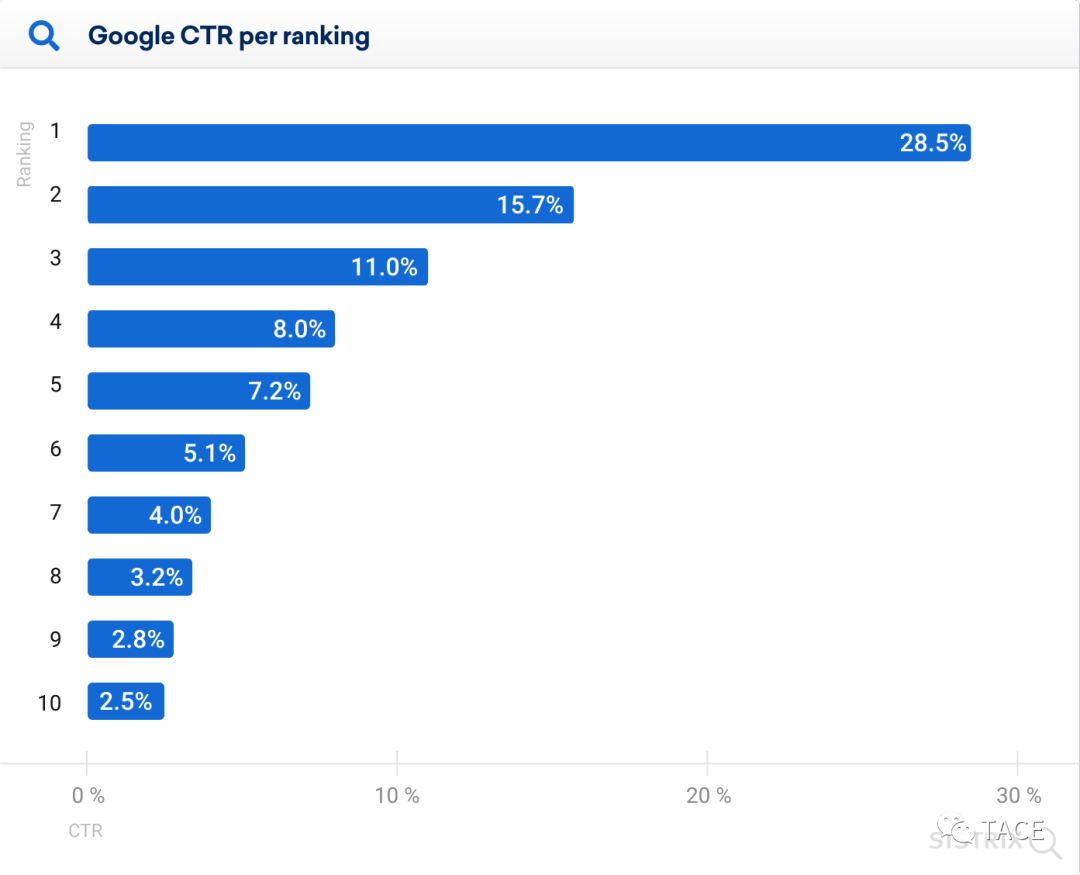

前面提到过,搜索流量在到达页面之前还有一个点击的步骤,以是我们应该把可获取流量盘算出来,公式为:

可获取流量 = 流量 X 点击率

点击率凭证排名估算,然则百度似乎从来没有公布过点击率数据,咳咳…

然则我们找到了一份Sistrix在2020年7月14日公布的google点击率数据,该数据剖析了跨越8000万的关键字和数十亿的搜索效果

虽然只是移动端的统计,但并无大碍

原文(英文):

https://www.sistrix.com/blog/why-almost-everything-you-knew-about-google-ctr-is-no-longer-valid/

每个关键词的可获取流量盘算完成后,我们的词库就搭建完毕了,Niceee!

6. 知乎数据获取

数据获取的目的是,我们能从这个N个维度的数据中,劈头判断出某个问题的难易度(对应9.1数据筛选)

数据在精不在多,过多的数据只会滋扰判断

-

问题浏览量

-

问题关注量(知乎站内流量)

-

问题确定时间

-

回覆数目

-

第1名赞数目

-

第1名回覆字数

-

第1名回覆时间

现在为止,我们需要的基础数据所有准备完毕,现在你应该获得了一个百度 + 知乎数据的关键词文件,good job!

若是你坚持到了这里,我信托,我会异常愿意熟悉你这样的同伙^_^

7. 数据剖析

7.1 关键词分组

面临海量杂乱无章的数据,我们需要通过关键词分组的形式,将相关的关键词和其对应的问题页面群集到一起

1)jieba分词

使用python-jieba模块,将每个关键词切分成N个词项(term),好比“流量能手”会被分词为“流量”+ “能手“,包罗相同词项的词视为一组

2)词项去重

参考【5.1母词获取】的去重部门

3)词项数据盘算

用每个词项去匹配关键词,并盘算匹配效果的数目(词频)和可获取流量总和

SEO的同伙们可能有种熟悉的感受,这种方式类似于搜索引擎的“倒排索引”,我们现实上就是以term为索引,归类了知乎URL

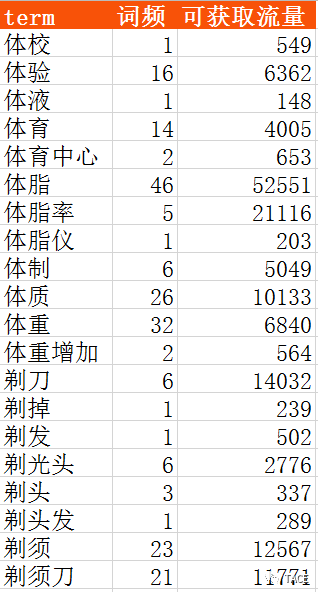

下面随便拿点演示数据:

7.2 人工分类

直接按词项分组是单纯从字符串角度上的分组,简朴粗暴但缺乏语义关系

好比“炒股”和“股票”这两个特征应该属于金融类,但按词项分组就会酿成两组,以是最后应该人工过一遍

分类完成后,将对应的词频和可获取流量总和相加,获得总数据

然后用头脑导图/表格的形式纪录,下面用头脑导图示例

然则记着,不要为了分组而分组,没有显著相关性的词项不应该被分到一组,否则那是在给自己找贫苦

8. 问题筛选

8.1 数据筛选

现在我们可以从可获取流量最多的种别中选取一个词项,在我们完成【6-7】后的关键词文件里,使用Bash shell 或者 在Excel-csv里搜索“关键词列”,找出包罗这个词项的关键词,然后用指标来筛选,下面给出几个筛选数值仅做参考

-

问题浏览量(辅助)

-

问题关注量(辅助)

-

问题确定时间(辅助)

-

回覆数目 <=50

-

第1名赞数目 <= 100

-

第1名回覆字数 <= 800

-

第1名回覆时间 (辅助)

-

可获取流量 >= 100

说一个场景,经由硬性指标筛选后,若是一个问题页面的浏览量远低于可获取流量,关注量少,问题确定时间为最近,第一名回覆时间为最近,那么这类问题需要重点mark一下

然则why?同伙们不妨自己思索一下

好啦我来告诉你,每一类人群的数目是有限的,若是把上面的条件反回来,那么很可能你已经miss掉一部门流量,以是我们要有抢占先机的意识

筛选完成后,可根据【可获取流量】或【第1回覆赞许数目】等条件降序排序,蓝海问题一目了然

8.2 人工筛选

人工主要来解决数据判断不了的内容问题,即第1名的回覆是否未知足问题需求,主要找以下2种类型:

1)直接知足,但用户的隐含需求未被知足,存在扩展空间

举例

Q:“汽车多久调养一次”

A:“我一样平常一季度调养一次”

A(new):“差异品牌的汽车调养时间差异,我下面列出所有品牌xxx,调养项目xxx,机油选择xxx,调养什么坑xxx”

2)间接知足

正好翻到一个,上图

回覆说明晰按键精灵,但并没有给出这个剧本怎么写

信托到了这里,你已经找到了N个种其余N个问题,然后马上最先剖析问题 > 列纲要 > xxxx…..

Stop!请马上住手你的上头行为,我们还有最后一步

9. 流量跟踪

万里长征最后一步,异常主要,异常主要,异常主要

我们前面提到2点:

-

在百度推广后台-关键词计划师中,流量的数据口径是月,而且是预估值

-

SE的网页排名是动态的

这就可能造成效果的不稳固性,辛辛劳苦做了数据,写了回覆,搞了排名,效果却没有阅读量?

以是我们要监控页面的浏览量是怎样增进的,来确定这个页面是否真的获取了流量,能获取若干流量,最终判断要不要回覆这些问题

监控时间单元可以是天,仔细点可以每N个小时,监控时长人人自己判断,固然越长越准确

举个例子,假设某个问题的可获取流量为15W,那么平均天天的可获取流量为5000左右,那么3天(不思考节沐日)的可获取流量为1.5W

纪录该页面的浏览量而且对比,只要上下浮动不是稀奇大,那么就可以列入我们的回覆清单

10.最后

我们将视角提升到整个营销的层面,会发现蓝海流量获取是整个营销环节的第一步,其他部门诸如回覆排名 & 流量路径 & 变现等

还有许多方式技巧类能辅助我们更好的使用蓝海流量

怎么学习SEO,你对SEO的认识够吗?SEO个人心得